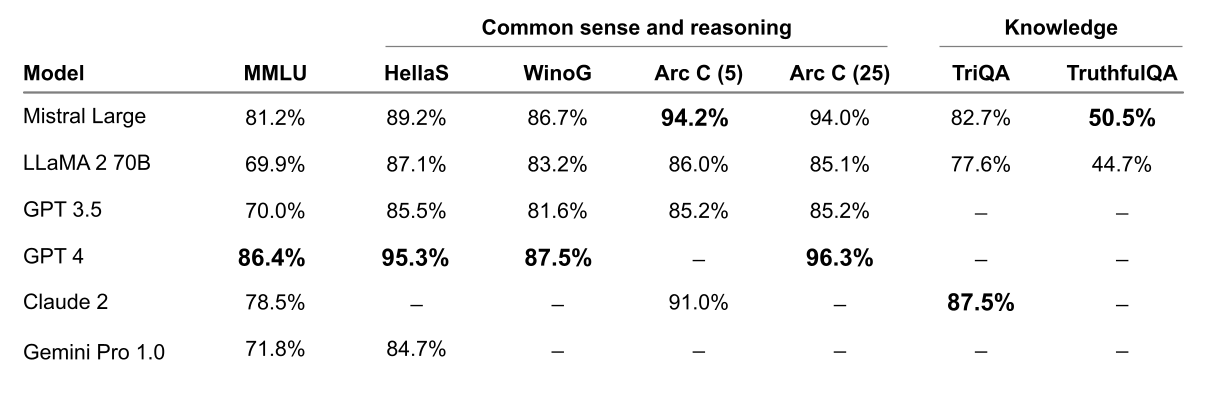

Figure 1 : Comparaison de GPT-4, Mistral Large (pré-entraîné), Claude 2, Gemini Pro 1.0, GPT 3.5 et LLaMA 2 70B sur MMLU (Mesure de la compréhension massive du langage multitâche).

(EN BREF) Mistral AI, une société d’IA, a présenté Mistral Large, son dernier modèle de langage avancé, offrant des capacités de raisonnement de haut niveau et une maîtrise multilingue. Il est désormais accessible via Azure, en plus de leur plateforme. Ils ont également lancé Mistral Small, optimisé pour les tâches à faible latence. Les deux modèles prennent en charge le format JSON et les appels de fonctions. Cette démarche vise à démocratiser l’IA en rendant les modèles de pointe facilement disponibles et conviviaux.

(COMMUNIQUÉ DE PRESSE) PARIS, le 26 février 2023 — /EuropaWire/ — Mistral IA, une startup française d’IA, est fière de dévoiler Mistral Large, notre dernière avancée en matière de technologie de modèle de langage. Bénéficiant de capacités de raisonnement inégalées, Mistral Large établit une nouvelle norme en matière de génération et de compréhension de textes. Disponible via la Plateforme et désormais accessible via Azure, Mistral Large marque une étape importante dans notre mission de démocratiser l’IA de pointe.

Conformément à notre engagement en faveur d’une accessibilité généralisée à l’IA, Mistral est heureux d’annoncer notre collaboration avec Microsoft Azure. Désormais, les développeurs peuvent accéder de manière transparente à Mistral Large via Azure AI Studio et Azure Machine Learning, débloquant facilement de puissantes capacités d’IA. Les clients bêta l’ont utilisé avec succès significatif. Nos modèles peuvent être déployés sur votre environnement pour les cas d’usage les plus sensibles avec accès à nos pondérations de modèles ; Lisez des témoignages de réussite sur ce type de déploiement et contactez notre équipe pour plus de détails.

Mistral Grandes capacités

Nous comparons les performances de Mistral Large aux meilleurs modèles LLM sur des critères de référence couramment utilisés.

Mistral Large fait preuve de puissantes capacités de raisonnement. Dans la figure suivante, nous rapportons les performances des modèles pré-entraînés sur des benchmarks standard.

Figure 2 : Performances sur des critères de bon sens, de raisonnement et de connaissances répandus des principaux modèles LLM du marché : MMLU (Mesure du langage multitâche massif dans la compréhension), HellaSwag (10 plans), Wino Grande (5 plans), Arc Challenge (5 tirs), Arc Challenge (25 tirs), TriviaQA (5 tirs) et TruthfulQA.

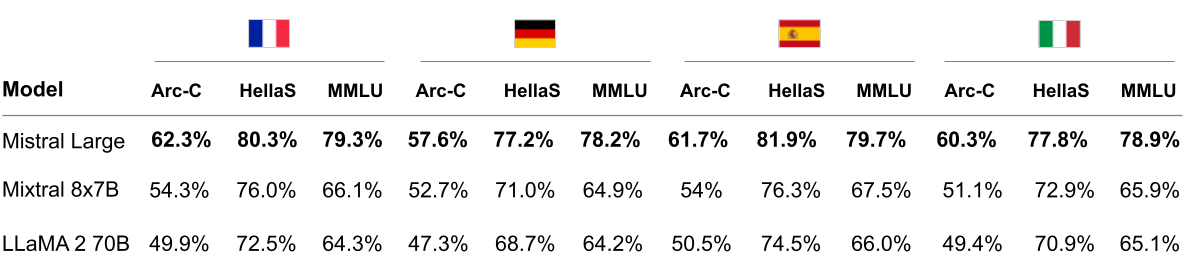

Mistral Large dispose de capacités natives multilingues. Il surpasse fortement LLaMA 2 70B sur les benchmarks HellaSwag, Arc Challenge et MMLU en français, allemand, espagnol et italien.

Figure 3 : Comparaison de Mistral Large, Mixtral 8x7B et LLaMA 2 70B sur HellaSwag, Arc Challenge et MMLU en français, allemand, espagnol et italien.

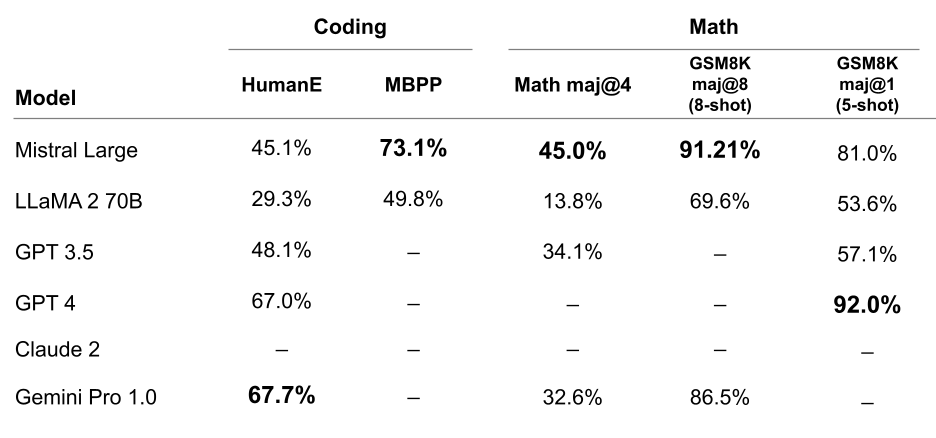

Mistral Large affiche des performances optimales dans les tâches de codage et de mathématiques. Dans le tableau ci-dessous, nous rapportons les performances d’une suite de tests de référence populaires pour évaluer les performances de codage et de mathématiques de certains des principaux modèles LLM.

Figure 4 : Performances sur les tests de codage et de mathématiques populaires des principaux modèles LLM du marché : HumanEval pass@1, MBPP pass@1, Math maj@4, GSM8K maj@8 (8-shot) et GSM8K maj@1 (5 tir).

En complément de Mistral Large, nous lançons également Mistral Small, un modèle optimisé conçu pour les charges de travail à faible latence. Offrant des performances supérieures et une latence réduite par rapport aux modèles précédents, Mistral Small comble le fossé entre nos offres à poids ouvert et notre modèle phare.

Pour rationaliser l’accessibilité, nous simplifions nos offres de points de terminaison, en proposant des points de terminaison ouverts à des prix compétitifs ainsi que de nouveaux points de terminaison de modèles optimisés. Nos benchmarks offrent des informations complètes sur les compromis en matière de performances et de coûts, permettant aux organisations de prendre des décisions éclairées.

Aux côtés de Mistral Large, nous lançons un nouveau modèle optimisé, Mistral Small, optimisé en termes de latence et de coût. Mistral Small surpasse le Mixtral 8x7B et présente une latence plus faible, ce qui en fait une solution intermédiaire raffinée entre notre offre open-weight et notre modèle phare.

Mistral Small bénéficie de la même innovation que Mistral Large en matière d’activation RAG et d’appel de fonctions.

Mistral Small et Mistral Large prennent désormais en charge le mode format JSON et les appels de fonctions, permettant une intégration transparente avec les flux de travail des développeurs. Cette fonctionnalité améliore l’interaction avec nos modèles, facilitant l’extraction de données structurées et les interactions complexes avec les systèmes internes.

Les appels de fonctions permettent aux développeurs d’interfacer les points de terminaison Mistral avec un ensemble de leurs propres outils, permettant des interactions plus complexes avec le code interne, les API ou les bases de données. Vous en apprendrez davantage dans notre guide d’appel de fonction.

L’appel de fonction et le format JSON ne sont disponibles que sur mistral-small et mistral-large. Nous ajouterons prochainement un formatage à tous les points de terminaison, ainsi que des définitions de format plus fines.

Mistral Large est désormais disponible sur la Plateforme et Azure, Mistral Small offrant des performances optimisées pour les applications sensibles à la latence. Mistral Large est également exposé sur notre démonstrateur bêta assistant, le chat. Essayez Mistral aujourd’hui et rejoignez-nous pour façonner l’avenir de l’innovation en IA. Nous apprécions vos commentaires alors que nous continuons à repousser les limites de la technologie des modèles de langage.

L’article a été publié pour la première fois à cette adresse EuropeWIRE.